- Votre choix linguistique sera sauvegardé.

- Votre agence sera enregistré.

- Votre session est sécurisée.

- Vous verrez la version standard de notre site web. Le contenu n'est pas adapté à vos préférences.

Giel Maris, gestionnaire de fonds chez Argenta Asset Management

La technologie évolue à toute vitesse et est partout autour de nous. Le thème New Tech regroupe les technologies de dernière génération qui occupent une place importante dans notre vie quotidienne.

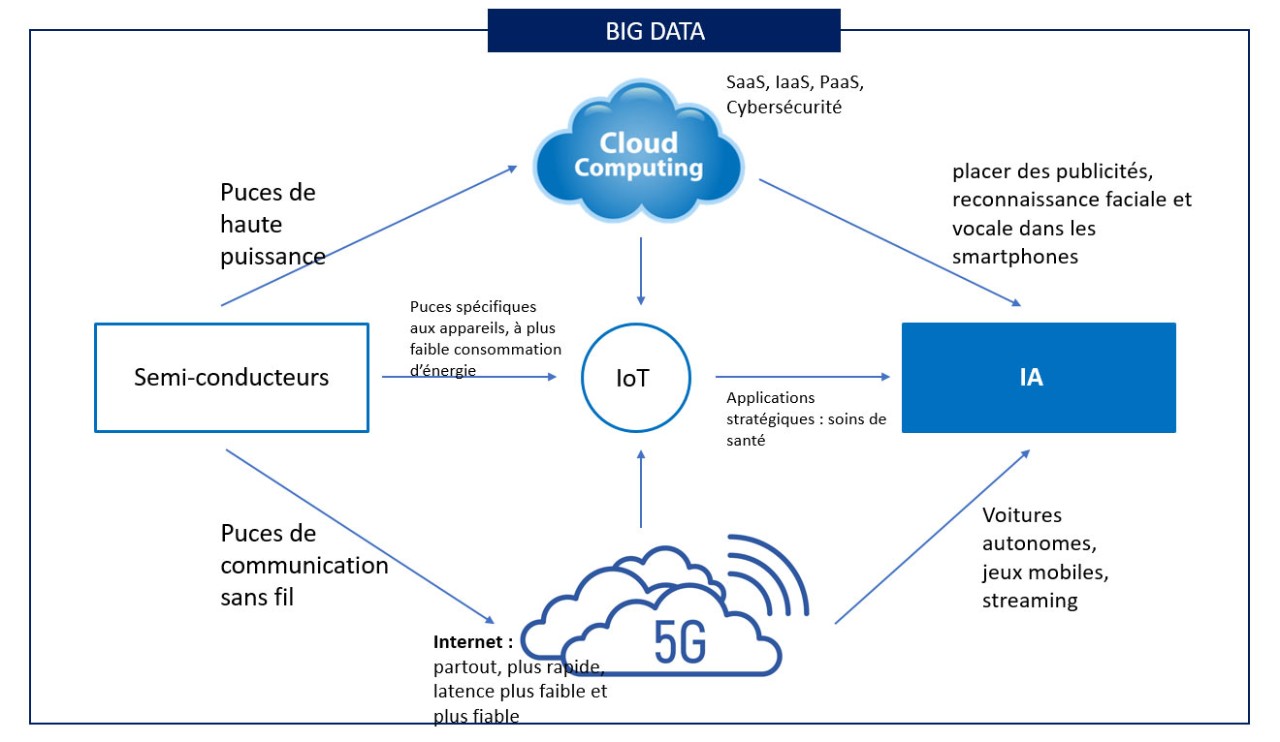

Quels sont les cinq principaux piliers de ce thème ?

- Connexion internet mobile (5G) : La connexion internet mobile est disponible dans un nombre toujours plus grand d’endroits et son fonctionnement est plus en plus rapide.

- Internet of Things : Nous connectons tous types d’appareils entre eux et au réseau internet afin de nous faciliter la vie.

- Intelligence artificielle : Les entreprises utilisent de plus en plus l’intelligence artificielle pour améliorer leur prestation de services.

- Big Data : Nous disposons d’un nombre toujours plus grand de données qui sont de plus en plus utilisées pour mieux connaître les besoins et les souhaits des clients.

- Cloud computing : Il n’est plus nécessaire d’acheter du matériel et des logiciels pour pouvoir les utiliser ; il vous suffit de les utiliser en ligne.

It’s all about Data. Big Data.

La technologie de l’information est devenue une industrie de plusieurs milliards de dollars grâce à des améliorations permanentes au niveau des coûts et de la facilité d’utilisation. Plus il est facile d’acheter, d’installer, d’entretenir et d’utiliser des systèmes informatiques, plus le marché disponible est grand. Tout l’écosystème numérique peut se résumer à une seule chose, le Big Data. D’ici 2025, on estime que le volume mondial de données s’élèvera à 175 zettaoctets (1 zettaoctet = 1 000 milliards de gigaoctets) par an, soit quatre fois plus qu’en 2020. L’adoption des médias sociaux, les données mobiles, le cloud et le thème bien connu de l’Internet des objets (Internet-of-Things ou IoT) contribuent à l’accélération des volumes de données.

Internet-of-Things (IoT)

On peut définir ce concept comme un réseau d’objets physiques qui sont connectés entre eux et échangent des données via internet. Tous ces objets ont un point en commun : ils sont alimentés par des semi-conducteurs. Ces puces sont également appelées les matières premières de l’écosystème numérique, car ce matériel est nécessaire pour faciliter l’infrastructure autour des données et les calculs effectués avec les données.

Infrastructure technologique

Par infrastructure, on entend le cloud computing et la 5G. Le cloud est un réseau mondial de serveurs externes (centres de données) qui fonctionnent comme un seul écosystème au-dessus de nos têtes. Pour le dire simplement, c’est internet. Les données sont désormais stockées sur des serveurs internet plutôt que sur le disque dur d’un ordinateur. De plus, le cloud facilite aussi l’accès aux données et les calculs (computing) effectués avec les données. En substance, le cloud computing simplifie considérablement le cycle de vie de l’achat, de l’implémentation et de la maintenance de l’infrastructure informatique des entreprises.

Ce concept peut être qualifié de plus grand bond en avant dans l’histoire de la technologie. En effet, les systèmes informatiques (infrastructure) sont devenus, tout comme l’électricité, un service d’utilité publique à la demande. Le développement logiciel peut lui aussi être classé comme un service d’utilité publique, étant donné que le cloud computing a permis d’en réduire considérablement les coûts et la complexité. Aujourd’hui, un développeur logiciel peut, à l’aide d’un ordinateur portable et d’une carte de crédit, créer et lancer des applications qui fonctionnent sur une infrastructure mondiale qui dessert des entreprises du classement Fortune 500*.

L’étape suivante dans l’écosystème numérique

Le cloud computing présente toutefois un point faible : son architecture centralisée. Cela contribue notamment à une moins grande flexibilité et à une latence plus élevée (le temps nécessaire pour qu’une demande soit transmise de l’expéditeur au destinataire et soit traitée par ce dernier). Conséquence : les applications stratégiques et critiques en termes de temps, notamment dans les secteurs de l’automobile et de la santé, ne peuvent pas se fier à la connectivité avec le cloud. C’est ici que la 5G entre en jeu pour résoudre le problème : la puissance de calcul et le stockage des centres de données cloud sont amenés vers un appareil qui fait partie du segment Internet-of-Things (IoT) ou vers un centre de données local. La combinaison du cloud computing et de la 5G est appelée edge computing. Ce concept va permettre de franchir l’étape suivante dans l’écosystème numérique.

*Fortune 500 est un classement d’entreprises américaines, classées selon l’importance de leur chiffre d’affaires annuel.

Intelligence artificielle

Les concepts de l’écosystème technologique qui viennent d’être cités ont tous une chose en commun, qui représente la plus grande opportunité pour l’économie mondiale : l’intelligence artificielle (IA). Il s’agit d’un terme générique désignant le matériel et les logiciels qui imitent les fonctions cognitives de l’homme et prennent des décisions sur la base d’informations provenant de l’environnement. Avec des consommateurs et des appareils de plus en plus connectés, des puces plus puissantes, un accès internet plus rapide et une infrastructure mondiale de cloud computing et 5G en pleine expansion, le développement de l’IA ne peut faire que s’accélérer. Ce concept va en effet contribuer à une transformation technologique radicale qui va très probablement toucher tous les segments de l’économie mondiale. Les voitures autonomes en sont une des applications modernes.

Conclusion

Le thème du New Tech a connu une reconnaissance accélérée ces dernières années et cette tendance se poursuivra dans les années à venir. La gestion des nouvelles technologies devient de plus en plus importante et complexe, et il s’agit donc d’un thème d’investissement intéressant. Une bonne diversification dans un portefeuille d’investissement bien équilibré est ici cruciale. Au sein des fonds essentiels, nous assurons une gestion active de la pondération de tous les thèmes à long terme. Nous avons par ailleurs des fonds complémentaires qui mettent davantage l’accent sur le thème de long terme « New Tech ».